SemanticLens

SemanticLens ist eine universelle Erklärbarkeitsmethode für große KI-Modelle, die eine systematische Analyse und Validierung der Modellkomponenten ermöglicht. Dies ist entscheidend, um Sicherheit und Transparenz in sicherheitskritischen Anwendungen zu gewährleisten. Die Einbettung des von den Komponenten kodierten Wissens in einen semantisch strukturierten Raum ermöglicht es Nutzern, die inneren Abläufe eines Modells umfassend zu durchsuchen, beschreiben, vergleichen und überprüfen.

Prototypical Concept-based Explanations

Konzeptbasierte Erklärungen verbessern unser Verständnis von tiefen neuronalen Netzen, indem sie die treibenden Faktoren einer Vorhersage in Form von für Menschen verständlichen Konzepten vermitteln. Es kann jedoch eine mühsame Aufgabe sein, jedes einzelne Beispiel zu untersuchen, um das Modellverhalten im gesamten Datensatz zu verstehen. Mit PCX (Prototypical Concept-based eXplanations) führen wir eine neuartige Erklärungsmethode ein, die ein schnelleres und einfacheres Verständnis von Modell(teil)strategien auf dem gesamten Datensatz ermöglicht, indem ähnliche konzeptbasierte Erklärungen in Prototypen zusammengefasst werden.

Concept Relevance Propagation

CRP ist eine neuartige Erklärbarkeitsmethode von tiefen neuronalen Netzen zum Verstehen von KI-Entscheidungen auf der Konzeptebene. Als Weiterentwicklung von LRP zeigt CRP für eine Entscheidung nicht nur auf, welcher Teil der Eingabedaten relevant ist, sondern kommuniziert, welche Konzepte genutzt werden, wo sie in den Eingabedaten lokalisiert sind und welche Teile des neuronalen Netzes dafür zuständig sind. CRP setzt mit einer hohen Zugänglichkeit für den Menschen neue Maßstäbe in der Validierung und Interaktion mit einer KI.

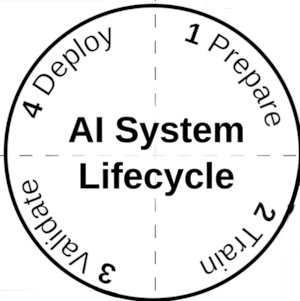

Prüfung, Absicherung und Zertifizierung von KI-Systemen

Das Fraunhofer Heinrich-Hertz-Institut (HHI) hat zusammen mit dem TÜV-Verband und dem Bundesamt für Sicherheit in der Informationstechnik (BSI) das gemeinsam entwickelte Whitepaper mit dem Titel "Towards Auditable AI Systems: From Principles to Practice" veröffentlicht, in dem die Verwendung einer neu entwickelten "Certification Readiness Matrix" (CRM) vorgeschlagen und ein erstes Konzept vorgestellt wird.

Fraunhofer Neural Network Encoder/Decoder (NNCodec)

Für die effiziente Codierung neuronaler Netze, hat das Fraunhofer HHI eine einfach zu nutzende und NNC-Standard-konforme Software – NNCodec – entwickelt und auf GitHub zur Verfügung gestellt.

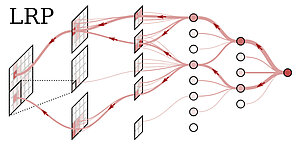

Layer-wise Relevance Propagation (LRP)

Layer-wise Relevance Propagation (LRP) ist eine patentierte Technologie zur Erklärung von Vorhersagen von tiefen neuronalen Netzwerken und anderen "Black Box" Modellen. Die von LRP produzierten Erklärungen (sog. Heatmaps) erlauben es den Anwender die Vorhersagen der KI zu validieren und potentielle Fehlermodi zu identifizieren.

Spectral Relevance Analysis (SpRAy)

XAI-Methoden wie LRP zielen darauf ab, die Vorhersage von ML-Modellen transparent zu machen, indem sie ein interpretierbares Feedback zu einzelnen Vorhersagen des Modells liefern und die Wichtigkeit von Eingangsmerkmalen in Bezug auf bestimmte Stichproben bewerten. Basierend auf diesen Einzelerklärungen erlaubt SpRAy, ein allgemeines Verständnis über die Empfindlichkeiten eines KI-Modells, gelernte Merkmale und Konzeptkodierungen zu erhalten.

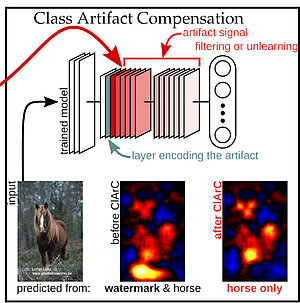

Class Artifact Compensation (ClArC)

Heutige KI-Modelle werden in der Regel mit extrem großen, aber nicht immer hochwertigen, Datensätzen trainiert. Unbemerkte Fehler in der Daten oder falsche Korrelationen verhindern oftmals, dass der Prädiktor eine gültige und faire Strategie zur Lösung der anstehenden Aufgabe lernt. Die ClArC-Technologie identifiziert potentielles Fehlverfahren eines Models anhand seiner (LRP) Erklärungen und retrainiert die KI gezielt, um das Problem zu lösen.